SEO ve İçerik Araştırması için “Kullanıcılar Bunları da Sordu” Kutuları Nasıl Ayıklanır?

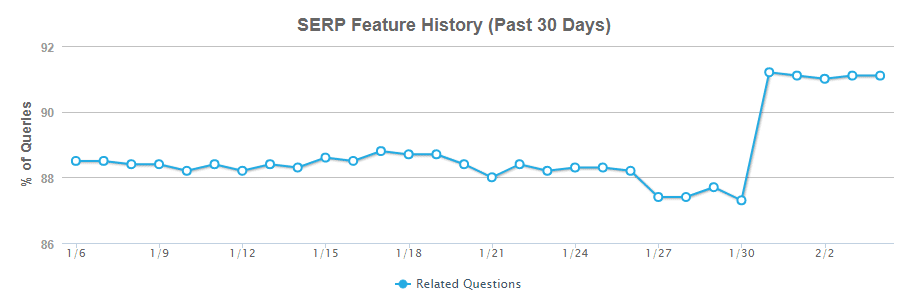

Kullanıcılar Bunları da Sordu (People Also Ask, PAA) kutuları 2016’da ilk çıktıklarından beri gitgide yaygınlaşan bir SERP (Arama Motoru Sonuç Sayfası) özelliğidir. Aslında Mozcast’ten yakın tarihli veriler, PAA’nın görüntüledikleri aramanın yaklaşık %90’ını meydana getirdiğini gösterir.

Google’ın makine öğrenme algoritmalarına bağlı olan bu kutu, kullanıcının ilk aramasıyla ilgili soruları gösterir. Örneğin, google.co.uk’de “bir bilgisayar nasıl çalışır” diye girerseniz şunları görürsünüz:

Başlangıçta, bu özelliğin SEO topluluğu arasındaki kabulü biraz sessizdi; muhtemelen birçoğu buna CTR’ları (organik tıklama oranlarını) yıpratmak için tasarlanmış başka bir özellik gözüyle baktılar; ama geçen dört yılda çok daha fazla sayıda insan kampanyalarını desteklemek için bu veriyi güçlü biçimde kullanmanın değerini kabul etti.

Bu veri nasıl kullanılır?

Bu yeni elde edilen veriyi kullanmanın üç yolu şöyle:

SSS sayfaları inşa etmek için soruları kullanmak

Bu taktiği birçok sitede kullandık ve Sık Sorulan Sorular’ın (SSS), müşteriler için PAA verisi kullanmada kıymetli bir kaynak olduğunu keşfettik.

Sayfaların hedeflenmesini sayfa başlıkları ve manşetleri, hatta yeni sayfa yaratmak yoluyla ayarlamak için bilgiyi kullanmak.

Anahtar kelimelerinizle ilişkili çekici konular, sitenizin içeriğini inşa etmenize ve kullanıcılara ek bilgi sağlamaya yardımcı olabilen PAA verilerinizi kullanılarak kolayca bulunabilir.

Öne çıkan snippet’leri tetikleyebilen ilgili soruları bulmak için Kullanıcılar Bunları da Sordu verisini kullanmak

Yanıtları bu sorulara göre listeler veya adım adım rehberler şeklinde biçimlendirerek snippet’lerde öne çıkmak mümkündür. Bu sizin SERP listelerindeki yerinizi kuvvetlendirecektir ve seçtiğiniz konuda web sitenize daha fazla ün ve otorite kazandırabilir.

Veriyi toplamak

PAA SERP özelliğini kullanma niyetiniz ne olursa olsun, ilk adım her zaman veri toplamak olacaktır. Bunu yapabileceğiniz birkaç yöntem var.

Manuel toplama

Sadece bir avuç anahtar kelimeye baktığınız senaryolarda manuel toplama hâlâ geçerli bir yaklaşımdır; sadece sorgularınızı içeri atıp öne çıkmanın tetiklenip tetiklenmediğine bakın. Tetiklenirse geri dönen uygulanabilir soruları not edin.

Derecelendirme izleme yazılımı kullanın

Birçok derecelendirme izleme yazılımı, hangi sorguların öne çıkan SERP’ler ürettiğini gösterir. Örneğin, Moz’da hesabınıza giriş yaparsanız ve Rankings > SERP Features’a giderseniz iki ok ikonuyla belirtilen sorguları görebilirsiniz.

Maalesef bu programlar üretilen soruları göstermez, yani listenizi daralttıktan sonra yine de onları kontrol etmeniz gerekir.

AWR gibi bazı programlar, arama motorunu “Google Universal”a ayarlarsanız ve anahtar kelime derecelendirme raporunuzda “Sonuç türü”nü işaretlerseniz size soruları özel bir raporda gösterecektir. Dikkat edin: 400 anahtar kelimeyi işlemek yaklaşık bir gün, 20.000 kelimeyi işlemek ise yaklaşık bir hafta sürebilir ve bu, raporu çalıştırmadan öncesidir, raporu çalıştırmak bir saat daha sürebilir.

Yukarıdakilere benzer bir araca erişiminiz ve onu kurcalayacak biraz zamanınız varsa önerim, onları kullanmanız olur. Erişiminiz ve zamanınız yoksa neyse ki başka bir seçenek var: Screaming Frog’a doğru bir adım adın!

Screaming Frog

Screaming Frog’un olması gerekenden daha az kullanılan en iyi özelliklerinden biri özel ayıklamadır (extraction). Bu, size endekslenebilir (crawlable) web sayfalarından herhangi bir bilgi parçasını alıp Screaming Frog veri havuzuna eklemenize olanak tanır.

Bu noktada, bunun teknik olarak Google’ın Hizmet Şartları’nı ihlal ettiğinin altını çizmeye değer. Derecelendirme izleme yazılımınızın günlük veya haftalık bazda yaptığı şeydir, o yüzden eminim bizi affedeceklerdir. Ne de olsa içeriğimizin ve web sitelerimizin kalitesini artırmayı amaçlıyoruz.

Böyle demişken, standart SF ayarlarınızı kullanırsanız hızla bir güvenlik kodunu (captcha) tetiklersiniz ve ayıklama işe yaramaz. O yüzden, hızınızı azaltmanız ve temkinli olmak isterseniz dilediğiniz konuma ayarlanmış bir VPN veya proxy sunucu kullanmanız çok önemlidir.

Aşağıdaki ayarlar genelde iyi çalışır ve SF’de Configuration > Speed altında ayarlanabilir.

Kullanıcı aracınızı, Configuration > User-Agent yoluyla Chrome olarak değiştirmenize de değer:

Ardından endekslemek (crawl) istediğiniz URL’lerin bir listesini toplamalısınız. Bir derecelendirme aracını kullandıysanız hangi sorguları kontrol etmek istediğinizi zaten biliyor olabilirsiniz. Bilmiyorsanız endişelenmeyin; binlerce sorguyu hiç sorun olmadan hâlâ devreye sokabilirsiniz. Excel gibi bir elektronik tablo programı kullanarak URL’lerimizi inşa edeceğiz. Şunun gibi bir şey yaratmak istiyoruz:

İlk sütunda Google’ın kullanmak istediğiniz versiyonunu girin (mesela https://www.google.co.uk) ve arama sorgusunun parametresini ekleyin (/search=?q=).

İkinci kolon arama sorgularınızı içermeli. Bunların URL’in bir kısmını oluşturacağını düşünürsek boşlukları “+” sembolüyle değiştirmeniz ve diğer bütün özel karakterlerden kaçınmanız gerekecek (bkz. URL kodaçımı). Son anahtar kelime listenizden memnunsanız “Bul&Değiştir” fonksiyonu bu işin kısa çözümünü yapabilir. Alternatif olarak, listenize sık sık yeni anahtar kelimeler eklemek ve bu görevi tekrar etme zahmetinden kaçınmak isterseniz YERİNE KOY işlevini kullanarak dinamik biçimde gerekli karakter değiş tokuşunu yapan, çalışan bir kolon yaratabilirsiniz.

İhtiyacınız olan bütün diğer parametreler, örneğin konum parametreleri için üçüncü bir kolon gerekir. Burada çoğu parametrenin listesini bulabilirsiniz (biraz eski tarihli ama henüz daha iyi bir kaynak bulamadım).

Son olarak, URL elemanlarının =CONCAT(A1:C2) kullanılarak birbirine bağlanması gerekir, böylece son bir diziliminiz olur.

Örnek:

Ayıklama henüz çalıştırılamaz; çünkü Screaming Frog’a sayfada ne bulması gerektiğini söylemedik!

Sırada ihtiyacınız olan şey, Scraper adındaki küçük Chrome uzantısı. Bu araç size bir web sayfasından veri seçmenize olanak tanıyarak benzer şeyleri bulmanıza olanak tanır ve amaçlarınız için daha önemli olarak sizin için XPath dizilimi yazmaya girişir.

Uzantı eklendikten sonra, “Kullanıcılar Bunları da Sordu” bölümünü öne çıkaran bir Google SERP’e yönelin. Sorulardan birini vurgulayın, sağa tıklayın ve diyalog kutusundan “benzerini ayıkla”yı seçin. Şanslıysanız bütün sorular sağ tarafta seçilir ve XPath sizin için yazılır. Gerçi durum pek böyle olmaz, kaynak kodun içine bakmanız gerekir. Sorulardan birini sağa tıklayıp inceleyin.

Bu, soruyu ve bağıntılı div sınıfını vurgulayacaktır.

Sonra ayıklayıcı aracınıza geri gidip ona dizilimi ekleyin ama şunu aklınızda tutun:

- XPath’a genellikle // ile başlamak istersiniz.

- Sonra muhtemelen HTML etiketine (bu durumda div’e) ihtiyacınız olur.

- Herhangi bir sınıf, id, vb. köşeli parantezlerin içinde biçimlendirilmelidir ve başında bir @ sembolü olmalıdır. Yani bu durumda [@class=”NWt7k”]

Bu, tüm dizilimimizin şöyle olması demek: //div[@class=”NWt7k”]

Bunu ayıklayıcı araca ekleyin ve ihtiyacınız olan bütün metnin çekildiğinden ve hiçbir ekstra bilgi bulunmadığından emin olarak “Ayıkla”ya basın. Bunun çalıştığından iyice emin olmak için aynı şeyi birkaç farklı SERP’te yapmaya değer.

Bağıntılı sınıf arada sırada değişir, o yüzden bu örnekteki dizilimi kullanıyorsanız ve bu dizilim çalışmıyorsa inceleme elemanını kullanarak DOM düğümünü kontrol edin ve gereken değişiklikleri yapın.

Sonrasında XPath diziliminin Screaming Frog’un Özel Ayıklama Menüsü’ne eklenmesi gerekir. Bu Configuration > Custom > Extraction’da bulunabilir.

Ayıklamaya mantıklı bir isim verin, böylece onu daha sonra kolayca bulabilirsiniz. Bu durumda, sağ taraftaki aşağı açılır menüde “Metni Ayıkla”nın seçili olduğundan emin olmak isteriz.

Şimdi URL listenizi içeri aktarabilir, endekslemeyi çalıştırabilir ve “özel” veya “dahili” raporların içine bakarak geri dönen soruları görebilirsiniz.

“Dışa aktar”a basarak bu değerli veriyi daha fazla analiz etmek için seçtiğimiz elektronik tablo programına aktarabiliriz.

Ayıklanabilen diğer Google verileri

Benzer mantık diğer Google özellikleri, örneğin AMP sonuçları, AdWords Reklamları, “… ilgili aramalar” ve SERP’lerin dahilindeki metin tabanlı herhangi bir ilave bilgi veya aslında web sitelerinizden başka herhangi bir bilgi için veriyi içeri çekmekte de uygulanabilir.

Mesela, PPC (tıklama başına ödeme) kampanyalarının potansiyel SEO trafiğini parçalayıp parçalamadığını analiz etmeye yardımcı olması için ayıklanmış AdWords verisini kullandık. Bu taktiğin, iki kanal arasında daha büyük bir sinerji oluşturma hususunda verimli olduğu ortaya çıktı; bu, organik trafiğin gelişmesini sağlarken PPC bütçeleri başka bir yere yeniden yatırılabilir. Nihayetinde bu yaklaşım, toplam ROI’ni (yatırım getirisi) ve müşterinin gelirini en üst seviyeye çıkarabilir.

Daha ileri bilgi için, Screaming Frog web ayıklama hakkında bir rehber sunar. “Kullanıcılar Bunları da Sordu” ve diğer özellikler için Google SERP’lerini ayıklamak, kullanıcıların hangi bilgileri aradıklarını bulmak için harika bir yoldur. Bunu içeriğinize veya SEO stratejinize eklemek, sayfalarınızı daha güçlü ve daha da önemli kullanıcılarınız için daha faydalı hale getirebilir.

İçerik Bulutu SEO Assistant eklentimizi kullandınız mı? İçerik Bulutu SEO Assistant eklentisi ile Google’da arama yaptığınız anahtar kelimede ilk 5 sırada yer alan içerikleri detaylı olarak analiz edebilir ve içerik çalışmalarınız için ilham alabilirsiniz. Eklentiyi hemen indirip ücretsiz olarak kullanın: https://akademi.icerikbulutu.com/extension/

Kaynak: https://builtvisible.com/scraping-people-also-ask-boxes-for-seo-and-content-research/

3 yorum var

Harika içerik için teşekkürler ! Bir de WordPress için nasıl ekleneceği konusunda yardımcı olursanız çok güzel olur.

Merhabalar, bir türlü cevabını bulamadığımı soru var. Yeni Landing page mevcut web site üzerinden yeni dosya açarak mı yoksa ayrı bir domain alıp kurmak mı yoksa mevcut domain üzerinden sub domain açarak mı yapmak doğru?

Merhaba Sami Bey,

Genele baktığımızda mevcut web site üzerinden yeni bir sayfa açmak en çok kullanılan yöntemdir. Ama bazı özel projeler için mikro site çalışması dediğimiz farklı domainden landing page hazırlanması da söz konusu olabiliyor.